AIのために設計。高速で、柔軟。

すぐに起動し、柔軟に拡張。予測可能なコストで

Runyour AIを運用できます。

Runyour AIは、GPU提供者と利用者をつなぐ韓国初のGPUマーケットプレイス。AI研究や専門的な計算処理に必要な高性能GPUを、オンデマンドで利用できます。

柔軟なプランで複数GPUにアクセス。研究・学習のパフォーマンスを最大化。

需要の変化に応じてリソースを拡張。容量からモデル学習まで柔軟に対応。

NVIDIA GPUを低遅延で実行。ボトルネックのない高速処理。

Runyour AI では、SSH を通じて GPU にアクセスし、

ご自身のローカル開発環境から作業することが可能です。

また、Jupyter Lab、VS Code、PyTorch、TensorFlow などの

主要なツールもプラットフォーム上で直接ご利用いただけます。

On-Demand は短期間の利用向けの従量課金型サービスです。

一方、Reserved Cloud は長期プロジェクト向けに

専用サーバーを月額契約で提供します。

はい、GPU は1枚ずつ個別に登録することが可能です。ただし、個別登録を行う場合は、CPU・RAM・ストレージもGPU 数に応じて按分して登録する必要があります。

現在、Runyour AI はLinux ベースの環境(Docker インスタンス上の Ubuntu)のみに対応しています。現時点では Windows には対応していません。

有料クレジットはユーザーが購入するクレジットで、GPU Cloud や Storage など、すべてのサービスで利用可能です。購入日から 1年間有効 です。ボーナスクレジットは、イベントやプロモーションを通じて付与され、同様にサービス利用が可能ですが、有効期限はキャンペーン内容によって異なります。※ クレジットは 1C = 1KRW として計算されます。

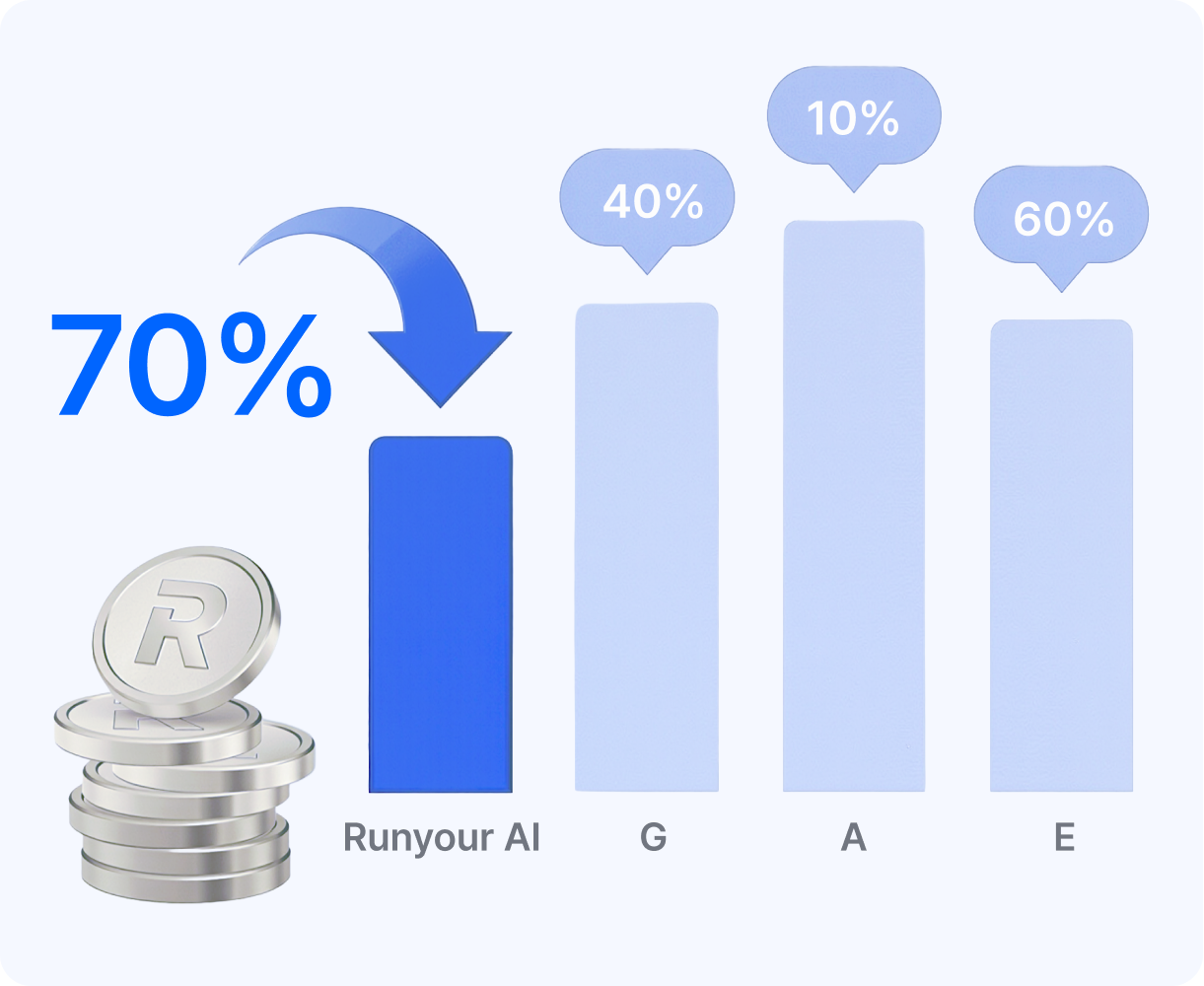

GPU 売上から 28% のマーケットプレイス手数料が差し引かれた後、

残額が支払われます。最終的な支払額は、契約条件および適用される税金によって異なる場合があります。